Transparence de la commande publique, des données aux politiques d’achat, quels usages ?

Retour sur le Forum Open d’Etat #5, l’occasion de faire l’état des lieux et de proposer des perspectives à l’avenir de la commande publique ouverte en France.

Le 12 décembre 2018, s’est tenu à Paris, à la Maison des Métallos, le cinquième forum Open d’État qui avait pour thème la transparence de la commande publique. En particulier, il a été question de l’engagement 2 du plan d’action national.

Parmi les sujets abordés : la publication des données essentielles de la commande publique en open data (les DECP), les récents développements d’outils facilitant leur lecture, les opportunités d’usages qui peuvent en être faits par des acteurs du privé et du secteur associatif.

Les discussions introductives ont fait place à deux ateliers de travail qui se sont attachés d’une part à explorer et évaluer les données et informations publiées lors du nouveau cadre législatif, et d’autre part à mieux connaître les usages et usagers des données de la commande publique.

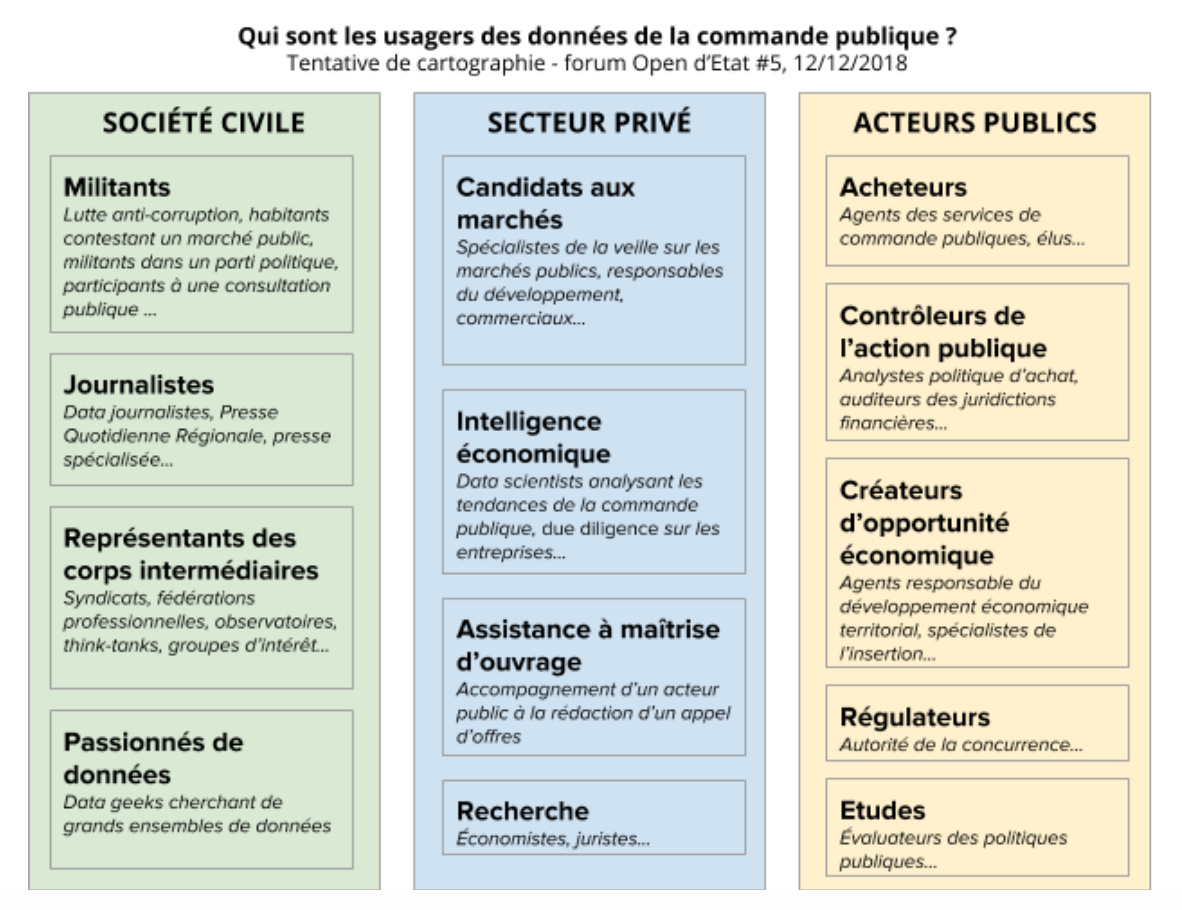

Le travail en ateliers a permis d’une part de réaliser une première cartographie des usagers de la commande publique et d’autre part de mieux comprendre l’expérience utilisateur relative à la recherche de données de la commande publique à l’échelle locale. L’identification d’une dizaine de profils a montré la diversité de métiers mobilisés dans l’analyse des marchés publics.

L’engagement 2 du plan d’action national a pour ambition de “publier en open data les données essentielles relatives à la commande publique, dans un standard international (Open Contracting Data Standard) en incluant l’ensemble des parties prenantes.”

La feuille de route prévoit des activités réparties sur les deux années du plan d’action, partant de la conception d’un flux unique de données des marchés publics (ou “flux marché”) ainsi que sa mise à disposition sur data.gouv.fr. Romain Talès, en charge de la publication de ces données à la mission Etalab a annoncé que cette étape avait été franchie.

L’engagement prévoit également le développement d’usages innovants des données de la commande publique au sein de territoires d’expérimentation comme la région Bretagne ou Occitanie. À ce titre, le forum a accueilli Céline Faivre, chief digital officer et directrice des affaires juridiques et de la commande publique à la Région Bretagne.

Afin de parler plus particulièrement des données et des usages que peuvent en faire des acteurs du privé et de la société civile, sont également intervenus Fréderic Oliveau, PDG d’Octopus Mind et spécialiste de la veille sur les marchés publics par les données, et Elsa Foucraut, responsable du plaidoyer chez Transparency International France.

Cela a permis d’introduire la possibilité d’élargir le périmètre des données intégrées au flux marché pour aller au-delà des données essentielles prévues par décret.

Comme pour chaque forum Open d’Etat, un kit d’appropriation a été transmis aux participants en amont pour assurer une meilleure compréhension des enjeux et donner les éléments de contexte nécessaires. Le kit présente les grands principes du gouvernement ouvert et de l’open data, le contexte juridique et les standards de l’ouverture des données de la commande publique ainsi que les initiatives internationales pour la transparence de la commande publique.

Compte-rendu des interventions

Elsa Foucraut, responsable du plaidoyer à Transparency International France

En introduction, Elsa Foucraut a rappelé que, pour Transparency International, les données ouvertes restent un levier encore peu exploité en France dans la lutte contre la corruption. Dans le cadre du G20, l’ONG a développé un plaidoyer sur l’open data. En 2017, Transparency International France a produit un rapport sur l’ouverture des données publiques utiles à la lutte contre la corruption en France.

Le rapport liste les jeux de données essentiels dans la lutte anticorruption selon TI :

1 - Le registre du lobbying

2 - Le registre des entreprises

3 - La liste des bénéficiaires effectifs des entreprises

4 - La liste des responsables publics

5 - Les finances publiques, budget et dépenses

6 - Le financement de la vie politique

7 - Les votes des parlementaires

8 - Le cadastre

9 - La commande publique

Elsa Foucraut a présenté un cas d’usage particulièrement représentatif du besoin des ONG à utiliser les données de la commande publique : Un membre de Transparency International en Europe a souhaité rechercher des données sur les marchés de téléphonie en France. Il a ainsi découvert que les données étaient difficiles à trouver, à identifier et à localiser au niveau géographique (recherche par villes).

Cela rejoint également les recommandations du rapport sur ce qu’il manquerait en France pour compléter et améliorer la qualité des données de la commande publique : une meilleure description des données et une granularité plus étendue.

Romain Talès, responsable du Pôle Données à Etalab et Marion Paclot, data scientist à Etalab

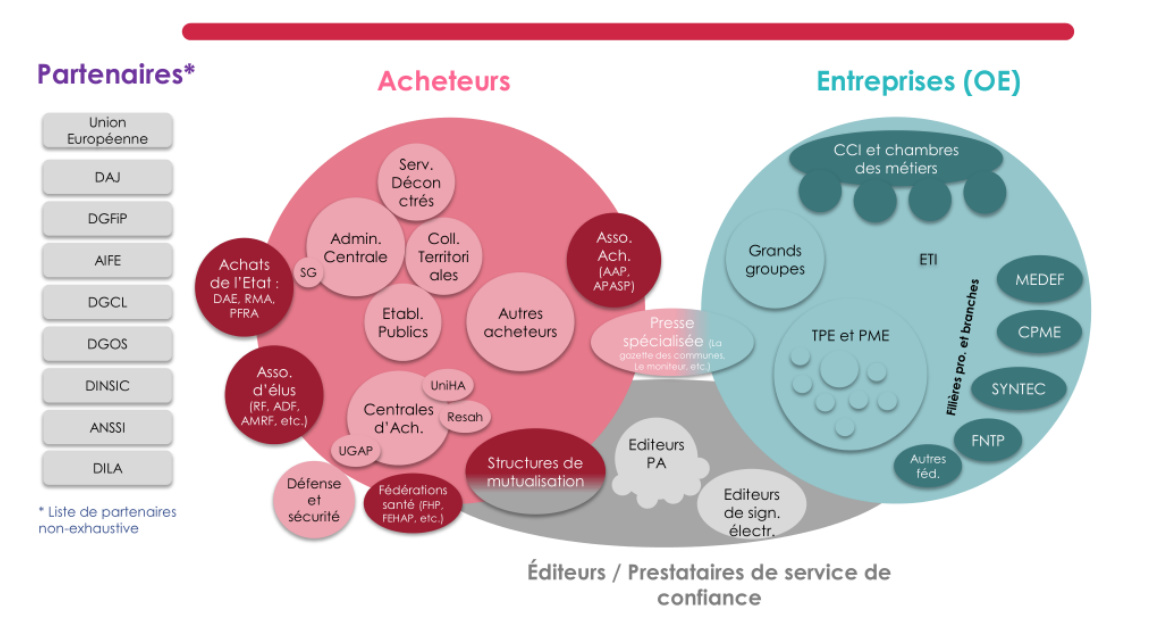

Romain Talès est revenu sur la genèse et la préfiguration des données essentielles de la commande publique (DECP), et rappelle que la création du flux unique a été le fruit d’une collaboration entre tous les acteurs concernés par la commande publique depuis plusieurs années. Le schéma suivant en montre la complexité.

Les données du flux unique PES marché (Protocole d’Échange Standard), proviennent d’Hélios, le système numérique de gestion des comptabilités des collectivités locales au sein de la DGFiP (Direction Générale des Finances publiques). Le PES marché n’est pas implémenté par l’ensemble des collectivités. Romain Talès précise que la montée en charge de la publication des données du PES sur data.gouv sera progressive depuis l’obligation de publication.

Une autre partie des données disponibles provient de PLACE, la plateforme des achats de l’État. L’AIFE (l’agence pour l’informatique financière de l’Etat), chargée de maintenir PLACE, transmet ces données directement sur data.gouv via l’API. (voir kit d’appropriation pour les définitions)

Marion Paclot rappelle que les données au format XML ne sont pas facilement accessibles ou lisibles pour du traitement analytique, or c’est le format de sortie des données du PES, mais aussi du BOAMP (Bulletin officiel des annonces des marchés publics). Les données du BOAMP, considérées comme riches, pourront être à terme ajoutées à l’ensemble des données disponibles, mais il reste encore un travail de nettoyage des données et d’harmonisation qui est en cours.

Exemple :

- Données publiées au BOAMP (Bulletin officiel des annonces des marchés publics) : seuil de publication des données pour les marchés d’un montant supérieur à 90 000€

- Données essentielles (DECP) publiées par obligation réglementaire : seuil de publication des données pour les marchés d’un montant supérieur à 25 000€

Marion Paclot travaille sur le développement d’un tableau de bord, un outil avec une interface utilisateur qui permettra aux personnes de naviguer dans les données, de filtrer les marchés attribués par activité, par ville ou par acteur. L’objectif est de rendre les marchés publics accessibles aux acteurs économiques intéressés comme les PME. Un autre objectif affiché est d’améliorer la détection de la fraude en identifiant des valeurs inhabituelles. Cette utilisation sert les acteurs de l’évaluation et de l’amélioration des politiques publiques. Par exemple, cela a déjà été mis en oeuvre par la cour des comptes.

Céline Faivre – Chief digital officer & directrice des affaires juridiques et de la commande publique à la région Bretagne

L’intervention a commencé par un rappel des contours de l’expérimentation de l’association Breizh Small Business Act, qui en 2015, a consisté à mettre à disposition les données de la commande publique au profit du développement de l’économie bretonne. Cette expérience a permis de préfigurer l’obligation de publication, la définition d’un format pivot standardisé, ainsi que l’automatisation de la collecte des données via les profils d’acheteurs. (Le portail de données ouvertes mis en oeuvre à l’occasion et toujours en ligne, permet de faire de l’analyse et de la visualisation de données.)

Les difficultés à publier et mettre à jour des données de qualité persistent malgré l’existence de données en quantité suffisante et régulièrement publiées. La dépendance avec les éditeurs de logiciel de gestion de ces données fait partie de ces difficultés et ne facilite pas l’amélioration des données existantes même numérisées, ni l’évolution des outils numériques mis à disposition.

Suite à cette expérimentation, la région Bretagne a continué la démarche de transparence et d’ouverture des données de la commande publique, et s’est fixée différents objectifs de politique d’achat et de pilotage sur base dʼindicateurs. (Voir le document Schéma des achats économiquement responsables présenté pendant l’intervention.) C’est un message fort qui passe bien auprès des élus. Les données permettent de repérer les offres anormalement basses, les ententes, etc.

La région s’engage aussi à enrichir les DECP avec les clauses sociales, un dispositif juridique permettant d’intégrer des considérations liées à la lutte contre le chômage et les exclusions dans les appels d’offres publics. Elles favorisent de fait l’accès des structures d’insertion par l’activité économique à la commande publique.

La région se fixe notamment l’objectif d’avoir 25% des marchés publics publiés contenant des clauses sociales (leur profil d’acheteur le permet). Un autre objectif poursuivi est de permettre aux petites entreprises de se lancer dans les marchés publics en facilitant leur accès à l’information et aux données concernant la programmation marchés ou les intentions dʼachat.

La région souhaite également favoriser la création de services publics grâce aux données de la commande publique, et lancera un datathon au premier trimestre 2019 pour poursuivre concrètement cette réflexion.

Frédéric Oliveau, PDG d’Octopus Mind

Frédéric Oliveau présente OctopusMind, un service de détection mondiale d’appels d’offres publics et privés. Le modèle économique d’OctopusMind est fondé sur l’analyse de données provenant d’appels d’offres publiés en France et à l’étranger. L’outil J360 d’OctopusMind propose une veille adaptée au secteur d’activité et au périmètre géographique des clients via des algorithmes. Pour réaliser cette offre, OctopusMind utilise entre autre les données du BOAMP et du TED (Tenders Electronic Daily), la version en ligne du «supplément au Journal officiel de l’Union européenne», consacré aux marchés publics européens. (Voir définition dans le kit d’appropriation)

Frédéric Oliveau indique qu’il est indispensable d’accompagner l’analyse de données avec un travail de sensibilisation aux entreprises clientes du service. Certaines présument le truquage de certains marchés et ne répondent pas pensant qu’elles ont peu de chances. La transparence de l’attribution des marchés permettra de démonter ce préjugé.

Pour OctopusMind, une autre idée intéressante de service basé sur la donnée pourrait être d’utiliser les données des clauses sociales qui favoriseraient l’insertion en permettant de mettre en relations les entreprises qui répondent aux marchés et les bénéficiaires de minima sociaux, via notamment des structures comme Pôle Emploi (alertes aux inscrits, mise à jour régulière et en direct avec l’emploi local…)

Les prochains développements de J360 vont dans ce sens : l’outil proposera déjà une prédiction du montant d’un marché et bientôt une analyse économique par pays et par zone géographique, en utilisant notamment les données de la base SIRENE.

Compte-rendu des ateliers

Atelier 1 – « Données » : Explorer et évaluer les données et informations publiées avec le nouveau cadre législatif.

Le premier atelier s’est attaché à confronter les informations et données disponibles avec plusieurs types d’utilisateurs potentiels : du néophyte au confirmé, les participants ont formulé des retours d’expérience précis à partir de 4 cas et consignes liées à la recherche d’information ou de données sur data.gouv.fr

- Lecture de l’article du blog Etalab “Le point sur les données essentielles de la commande publique”

- Rechercher sur Data.gouv les données de la commande publique pour une ou plusieurs collectivités.

- Chercher les données du PES marché sur Data.gouv

- Chercher le tag DECP sur Data.gouv

Des outils et fiches d’animation ont été créés afin de guider les participants dans la formulation d’un petit rapport d’étonnement sous forme d’une fiche A4. Pour chaque consigne il fallait :

- Expliquer les étapes et les attentes de la recherche, décrire le résultat attendu ainsi que le résultat réel.

- Formuler des remarques constructives sur les aspects à améliorer.

- Formuler des retours sur les éléments à garder.

Atelier 2 – « Usages » : Mieux connaître les usages innovants liés aux données de la commande publique

Le deuxième atelier visait à connaître les usagers des données publiques afin de mieux répondre à leurs besoins. Pour se mettre à la place des usagers, la méthode choisie a été celle des personas, des personnages fictifs auxquels on donne des caractéristiques qui représentent un groupe d’usager. Cette approche permet, en appréhendant les pratiques et les principaux traits d’un personnage archétypale, de créer un projet d’open data guidé par la demande et de saisir les besoins en termes de documentation, de format voire d’accompagnement.

L’atelier s’est déroulé en deux grandes parties. Dans un premier temps, les participants ont listé les grands types de réutilisateurs de la commande publique, de la manière la plus large possible dans un délai limité.

Ensuite, les participants ont rassemblé ces catégories d’usagers dans de grandes familles de réutilisateurs répartis entre la société civile, le secteur privé et les acteurs publics.

Ce travail a permis de réaliser une première cartographie des usagers de la commande publique, un travail qui n’avait jusqu’alors pas été réalisé en France selon plusieurs participants à l’atelier. Cette cartographie, bien sûr non exhaustive, montre la diversité des profils d’usagers de la commande publique et la variété des métiers mobilisés dans l’analyse des marchés publics.

Annabelle 33 / Data-scientist dans une SS2I / après une reconversion

Perception des données essentielles : il est compliqué de trouver les données, les acronymes sont incompréhensibles, il n’y a pas de documentation et la nomenclature est difficile

Objectif : Elle doit faire une étude pour un marché public de leasing pour un constructeur, mais elle ne connaît pas comment fonctionne la fonction publique. Elle a acheté un livre sur la commande publique, elle décide de travailler sur PLACE, mais elle trouve qu’il y a trop de sources d’information sur le sujet.

Camille 37 / Travaille à Pôle emploi, elle s’occupe des demandeurs de longue durée

Elle a un ami qui travaille à la mairie de Nantes qui essaie de mettre des clauses sociales dans les marchés publics. Il constate que les entreprises ne répondent pas à ces clauses (Notamment dans le secteur des graphistes). Par instinct elle se dit qu’il y a des choses à faire, mais elle ne connaît pas les données essentielles. Il faudrait qu’elle se forme, quelle trie les données et quelle mette en contact les acheteurs et les profils. Les parties prenantes possibles:

Mairie de Nantes

La bonne boite avec le BOAMP /données essentielles

Georges 45 ans / il travaille pour une collectivité locale

Suit le mouvement de l’open data. Il est enthousiaste :

Opportunité pour le benchmark

Acheter un certain nombre de contrat

Il se demande quand ça va vraiment s’ouvrir ?

Bill, 40 ans économiste (public ou privé) → il analyse les données pour essayer de comprendre le tissu économique etc. Il doit souvent s’adresser à des journalistes pour savoir où est ce qu’on en est etc.

Asis 21 ans - Informaticien dans une ONG

Il fait de la veille et essaie de repérer les anomalies dans les données pour détecter les cas de correction, mais il trouve qu’il existe un problème de volume et de qualité.

Bob 55 ans - Magistrat dans une chambre des comptes des collectivités locales

Données de la commande publique très intéressantes mais il ne comprend pas techniquement comment ça fonctionne. Il faudrait une application de data-visualisation avec des menus déroulants. Mais il restera le problème de la qualité de la donnée. Attention, car si les données qu’il voit ne sont pas bonnes, il peut se braquer

Camille – Commission européenne

Elle travaille à l’élaboration de politiques publiques. Elle pense que la collecte et l’utilisation des données de la commande publique peut simplifier son travail (dans la collaboration avec d’autres services ou encore en aval). Le problème reste la qualité des données. Dans son environnement la culture des données n’est pas encore très valorisée.

Isabelle 42 ans – Responsable vente dans une PME

On lui demande souvent de répondre à des appels d’offre de marchés publics. Mais elle trouve que c’est long et complexe. Son neveu qui travaille pour le PTNCP lui parle des données essentielles pour l’aider (visibilité du marché, analyse concurrentielle, aide à la décision). Mais quand elle se connecte à data.gouv elle tombe sur des données non structurées. Elle ne sait pas si elle attend que l’administration développe un outil de data visualisation ou si elle demande à ses équipes techniques de développer en interne un outil.

Isidore Data journaliste, Science po et geek, Stage à Libération

Il ne connaît rien au marché public. Il veut s’appuyer sur des données pour faire des visualisations et argumenter. Il cherche sur data gouv mais il trouve cela peu structuré. Il est obligé de compléter les articles par des interview. Finalement, il se fait aider par les informaticiens de Libération et avec l’exploitation des données il trouve enfin des sujets d’articles. Mais ces dernières nécessitent d’être complétées.